- Hugging FaceがSambaNova等と提携し、新機能「Inference Providers」を発表。

- 開発者が選択したインフラでAIモデルを容易に実行可能に。

- サーバーレス推論の提供に重点を置き、複数のプロバイダーと連携。

新機能「Inference Providers」の概要

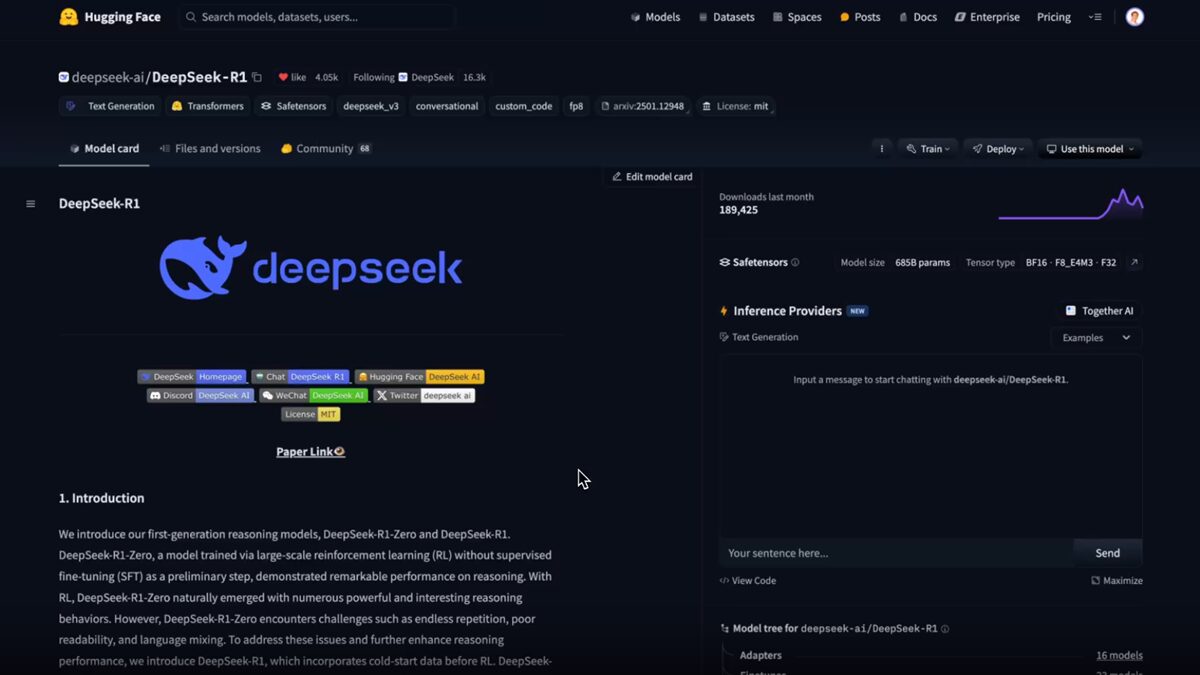

AI開発プラットフォームのHugging Faceは、SambaNova等のサードパーティクラウドベンダーと提携し、開発者がより柔軟にAIモデルを実行できる新機能「Inference Providers」を発表した。この取り組みにはFal、Replicate、Together AIも参加している。

Hugging Faceによると、各パートナー企業はHugging Faceのプラットフォームから自社のデータセンターにアクセスできるよう連携を進めてきた。これにより、開発者は例えばHugging Faceのプロジェクトページから数クリックでSambaNova社のサーバー上でDeepSeekモデルを起動できるようになった。

Hugging Face

同社のブログ投稿で、「サーバーレスプロバイダーが発展し、優れたプロバイダーを通じてサーバーレス推論への簡単で統一されたアクセスを提供する時期が来た」と説明している。サーバーレス推論により、開発者は基盤となるハードウェアの設定や管理を行うことなく、AIモデルのデプロイとスケーリングが可能になる。SambaNova等のプロバイダーは、使用状況に応じて必要な計算リソースを自動的に起動し、スケールの調整を行う。

料金体系と今後の展開

Hugging Faceは、プラットフォームを通じてサードパーティクラウドプロバイダーを利用する開発者に対し、当面は標準的なプロバイダーのAPI料金を適用するとしている。全ユーザーに推論用の少額のクレジットが提供され、プレミアム層のHugging Face Proの購読者には毎月2ドル(約300円)の追加クレジットが付与される。

Hugging Faceの成長

2016年にチャットボットスタートアップとして設立されたHugging Faceは、現在、世界最大規模のAIモデルホスティングおよび開発プラットフォームの1つとなっている。これまでにSalesforce、Google、Amazon、Nvidiaなどの投資家から約4億ドル(約600億円)の資金を調達しており、収益性も確保していると主張している。

引用元:TechCrunch

Hugging Face makes it easier for devs to run AI models on third-party clouds