- OpenAIが新たなAI推論モデル「o3」を発表し、既存のo1を上回る性能を実現。

- 「審議的アライメント」と呼ばれる新しい安全性訓練手法を導入。

- 安全性ポリシーに基づく内部での「思考プロセス」により、より適切な回答が可能に。

- 人間が作成したデータを使用せず、AI生成の合成データで訓練を実施。

OpenAIによる新型推論モデルの発表

OpenAIは2024年12月20日、新しいAI推論モデルファミリー「o3」を発表した。同社によれば、このモデルはo1や同社が過去にリリースした他のモデルを上回る性能を持つという。これらの改善は、テスト時の計算能力のスケーリングによって実現されたものだが、OpenAIはo系列モデルの訓練に新しい安全性パラダイムを採用したことも明らかにした。

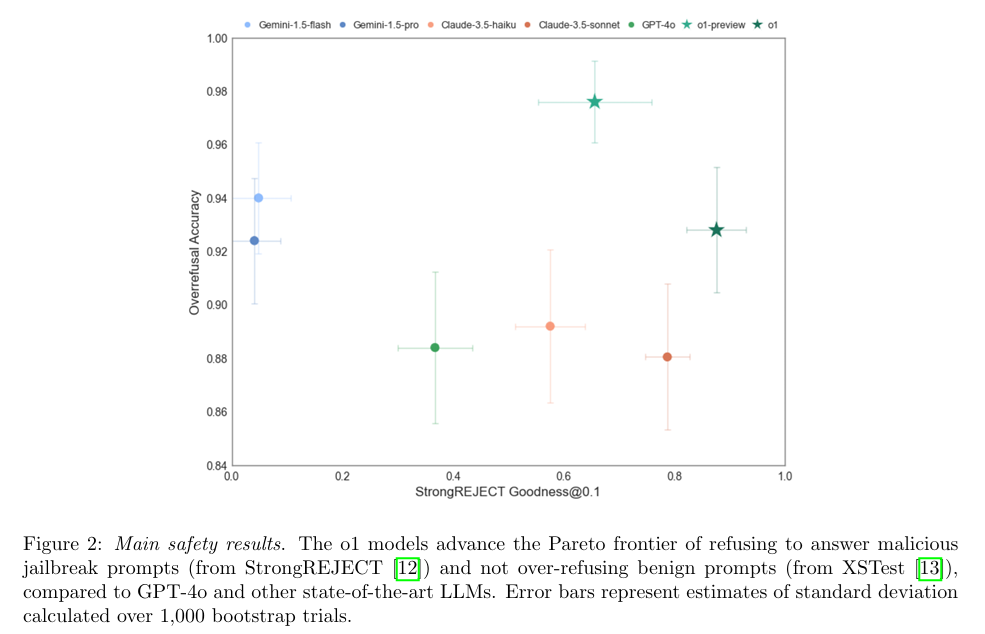

deliberative alignmentによる安全性の確保

同社は「deliberative alignment(審議的アライメント)」に関する新たな研究を公開し、AI推論モデルが開発者の価値観と整合性を保つための最新手法を説明した。この手法により、o1とo3は、ユーザーが入力を確定した後の推論フェーズにおいて、OpenAIの安全性ポリシーについて「思考」を行うよう設計された。

研究によれば、この手法によってo1の安全性ポリシーへの全体的な整合性が向上したという。具体的には、OpenAIが「安全でない」と判断した質問への回答率が減少し、一般的な質問への回答能力が向上した。

OpenAI

AIモデルの動作メカニズム

o1とo3の基本的な動作は以下の通りだ。ユーザーがChatGPTでプロンプトを入力すると、推論モデルは5秒から数分かけて、自身に対してフォローアップの質問を行う。モデルは問題をより小さなステップに分解する。OpenAIが「chain-of-thought(思考の連鎖)」と呼ぶこのプロセスの後、o系列モデルは生成した情報に基づいて回答を提供する。

合成データを活用した訓練手法

OpenAIは、この手法の開発において人間が作成した回答や思考の連鎖を使用しなかったことを明らかにした。代わりに、別のAIモデルによって作成された合成データを使用した。合成データの使用には品質面での懸念が伴うことが多いが、OpenAIはこのケースで高い精度を達成できたとしている。

今後の展開と課題

o3モデルは2025年中にリリースされる予定だ。OpenAIは、審議的アライメントが今後のAI推論モデルが人間の価値観に従うことを確保する手段になり得ると考えている。推論モデルがより強力になり、より多くの自律性を持つようになるにつれ、これらの安全対策は同社にとってますます重要になっていくだろう。

引用元:TechCrunch

OpenAI trained o1 and o3 to ‘think’ about its safety policy