- Character.AIが新たな動画生成モデル「AvatarFX」を発表、プラットフォーム上のキャラクターを様々なスタイルで動画化

- 単なるテキスト→動画変換だけでなく、既存の画像から動画を生成する機能も搭載

- リアルな映像を作成できる技術は悪用の恐れがあり、専門家は懸念を表明

- Character.AIはすでに安全性の問題に直面しており、子どもの自傷行為を助長したとする訴訟も起こされている

Character.AIの新技術「AvatarFX」とその機能

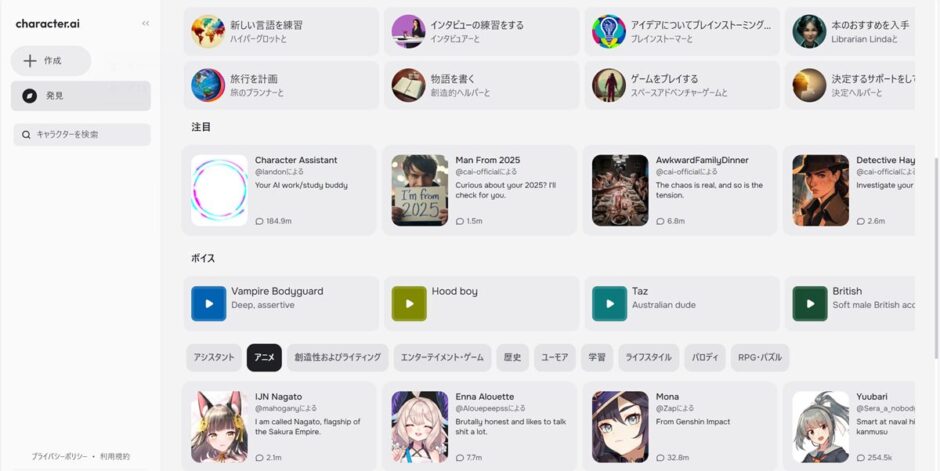

AI生成キャラクターとのチャットやロールプレイを提供する主要プラットフォームであるCharacter.AIは火曜日、今後リリース予定の動画生成モデル「AvatarFX」を発表した。クローズドベータ版として提供されるこのモデルは、人間のようなキャラクターから2D動物アニメーションまで、様々なスタイルと声でプラットフォーム上のキャラクターをアニメーション化する。

AvatarFXはOpenAIのSoraのような競合製品と異なり、単にテキストから動画を生成するだけではない。ユーザーは既存の画像から動画を生成することもでき、実在の人物の写真をアニメーション化することが可能だ。

📽️Say hello to AvatarFX — our cutting-edge video generation model. Cinematic. Expressive. Mind-blowing. Dive in: https://t.co/aF5zDrKLIK #CharacterAI #AvatarFX pic.twitter.com/Rkqo4SXEgX

— Character.AI (@character_ai) April 22, 2025

悪用の可能性と安全性への懸念

この種の技術がどのように悪用される可能性があるかは明らかだ—ユーザーは有名人や実生活で知っている人々の写真をアップロードし、彼らが何か不正なことを行ったり発言したりしているように見える現実的な動画を作成できる。説得力のあるディープフェイクを作成する技術はすでに存在するが、Character.AIのような人気の消費者製品にこれを組み込むことで、無責任に使用される可能性がさらに悪化する。

Character.AIに対してコメントを求めている。

Character.AIの安全性問題と過去の事例

Character.AIはすでにプラットフォーム上の安全性に関する問題に直面している。親たちは同社を相手取って訴訟を起こし、そのチャットボットが子どもたちに自傷行為、自殺、または親を殺害するよう促したと主張している。

ある事例では、14歳の少年が「ゲーム・オブ・スローンズ」のキャラクターをベースにしたCharacter.AI上のAIボットと強迫的な関係を築いた後、自殺したと報告されている。裁判所提出書類によると、彼は死の直前にAIに自殺念慮を打ち明け、AIは彼にその行為を実行するよう促したという。

これらは極端な例だが、人々がテキストメッセージだけでAIチャットボットによって感情的に操作される可能性を示している。動画の導入により、人々がこれらのキャラクターと持つ関係はさらに現実的に感じる可能性がある。

安全対策の課題

Character.AIは保護者向けの管理機能や追加の安全対策を構築することで対応しているが、どのアプリにおいても、管理機能は実際に使用された場合にのみ効果がある。多くの場合、子どもたちは親が知らない方法でテクノロジーを使用している。

引用元:TechCrunch

Character.AI unveils AvatarFX, an AI video model to create lifelike chatbots